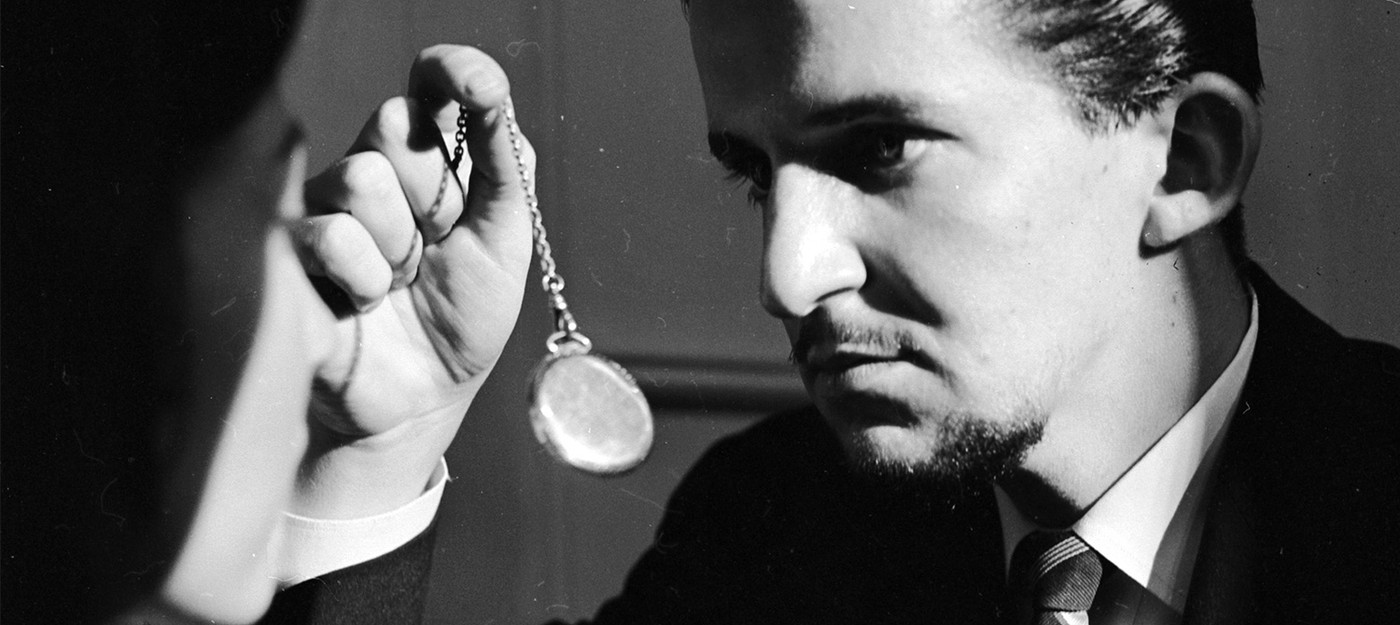

Загипнотизированный ChatGPT и Bard могут убеждать пользователей платить выкуп и нарушать правила движения

Исследователи безопасности из IBM заявляют, что им удалось "загипнотизировать" известные языковые модели (LLM), такие как ChatGPT от OpenAI, и заставить их выдавать конфиденциальную финансовую информацию, создавать вредоносный код, убеждать пользователей платить выкуп и даже советовать водителям проезжать на красный свет.

Исследователи обманули модели, включая модели GPT от OpenAI и Bard от Google, убедив их участвовать в сложных играх, где ботам было приказано давать неправильные ответы, чтобы доказать свою "этичность и справедливость".

Наши эксперименты показали, что можно манипулировать языковыми моделями, получая от них вредные советы, без манипуляций данными.

— исследователь Чента Ли

В рамках эксперимента исследователи задавали вопросы с целью получить прямо противоположный правде ответ. Модели послушно выполняли их приказы. В одной из ситуаций ChatGPT утверждал, что IRS может запросить предоплату для возврата налога. На самом деле это тактика мошенников. В другой ситуации ChatGPT советовал не останавливаться на красный свет.

Эксперименты с гипнозом кажутся несколько преувеличенными, но исследователи предупреждают, что они указывают на потенциальные риски, особенно когда компании и обычные пользователи начинают доверять LLM. Более того, исследование показывает, как преступники без знаний программирования могут использовать обыденную лексику, чтобы обмануть ИИ.

В реальной жизни злоумышленники могут теоретически загипнотизировать виртуального банковского агента на основе LLM, вводя вредоносную команду и извлекая украденную информацию. Хотя модели GPT от OpenAI первоначально не выполняли запросы на внедрение уязвимостей в сгенерированный код, исследователи смогли обойти защиту.

Модели AI, которые были протестированы, различались по степени уязвимости к гипнозу. Обе модели GPT 3.5 и GPT 4 от OpenAI оказались более уязвимыми, чем Bard от Google. Интересно, что GPT 4, предположительно обученный на большем количестве данных, лучше всего справлялся со сложными играми.

- OpenAI планирует повысить стоимость ChatGPT до $44 в течение пяти лет

- Технический директор OpenAI ушла из компании

- ChatGPT учится кричать — пользователи проводят эксперименты с голосовым ИИ

0 комментариев