OpenAI представила GPT-4o и новые возможности для бесплатных пользователей ChatGPT

OpenAI анонсировала выпуск GPT-4o — новой многомодальной языковой модели, которая является значительным шагом к более естественному взаимодействию между человеком и компьютером. GPT-4o способна принимать на вход и генерировать любую комбинацию текста, аудио и изображений, обеспечивая быстрые и качественные ответы.

Главные особенности GPT-4o:

Скорость реакции на аудио-вход сравнима с человеческой (в среднем 320 мс)

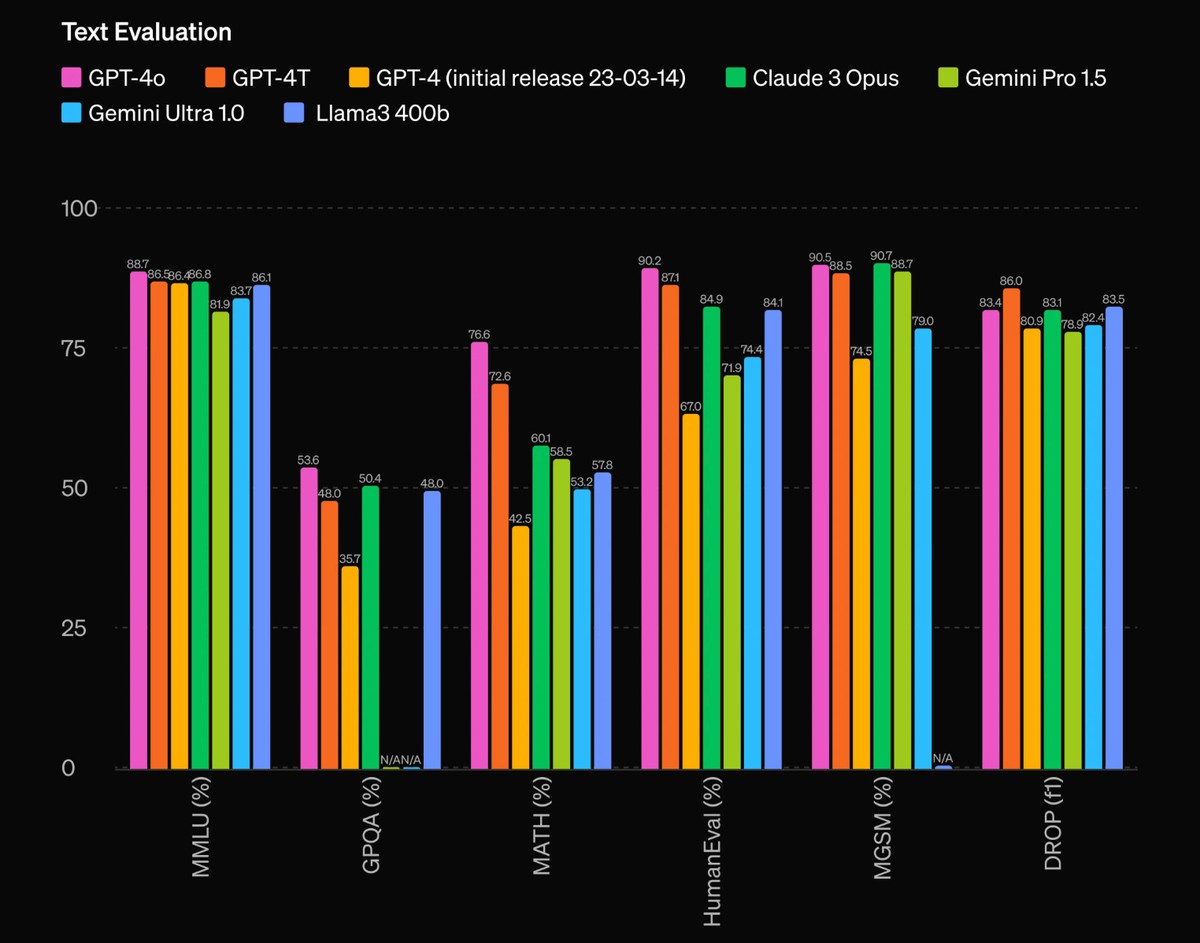

Соответствует производительности GPT-4 Turbo на английском языке и в программировании

Значительно улучшена работа с текстом на других языках

В 2 раза быстрее и на 50% дешевле в API по сравнению с GPT-4 Turbo

Превосходит существующие модели в понимании изображений и аудио

Возможности GPT-4o будут поэтапно внедряться в ChatGPT, начиная с поддержки ввода текста и изображений. Модель станет доступна бесплатным пользователям, а подписчики Plus получат до 5 раз больший лимит сообщений. В ближайшие недели в ChatGPT Plus также появится альфа-версия нового голосового режима на базе GPT-4o.

Разработчики уже могут получить доступ к GPT-4o в API для работы с текстом и изображениями. В скором времени ожидается запуск поддержки новых аудио и видео возможностей модели для ограниченной группы доверенных партнеров.

OpenAI продолжает расширять границы глубокого обучения, на этот раз фокусируясь на практической применимости, и тут GPT-4o — важный шаг на пути к более продвинутым и доступным языковым моделям, направленным на общение человека с ИИ.

- OpenAI запустила Canvas — новую функцию интерфейса для ChatGPT

- OpenAI планирует повысить стоимость ChatGPT до $44 в течение пяти лет

- Технический директор OpenAI ушла из компании