Натренированный на 4chan ИИ оказался токсичной тварью

В прошлом Microsoft на своем примере показала, как без надлежащего надзора и контроля ИИ может стать расистом. Но что будет, если кто-то намеренно возьмется за создание бота, натренированного при помощи токсичного форума? Один разработчик выяснил это на своем примере.

Как сообщило Motherboard, ютубер Янник Килчер натренировал языковую модель ИИ, используя контент, накопленный на доске Politically Incorrect (/pol/) в 4chan за последние три года. Для тех кто не в курсе, эта доска известна своим жестким расизмом и прочими грехами.

После внедрения модели в 10 ботов, Килчер отправил их покорять /pol/. Неудивительно, что это создало целую волну ненависти. Всего за 24 часа боты написали 15 тысяч постов, часто включая или взаимодействуя с расистским контентом. В общей сложности они же представляли собой около 10% от всех постов в /pol/ за день.

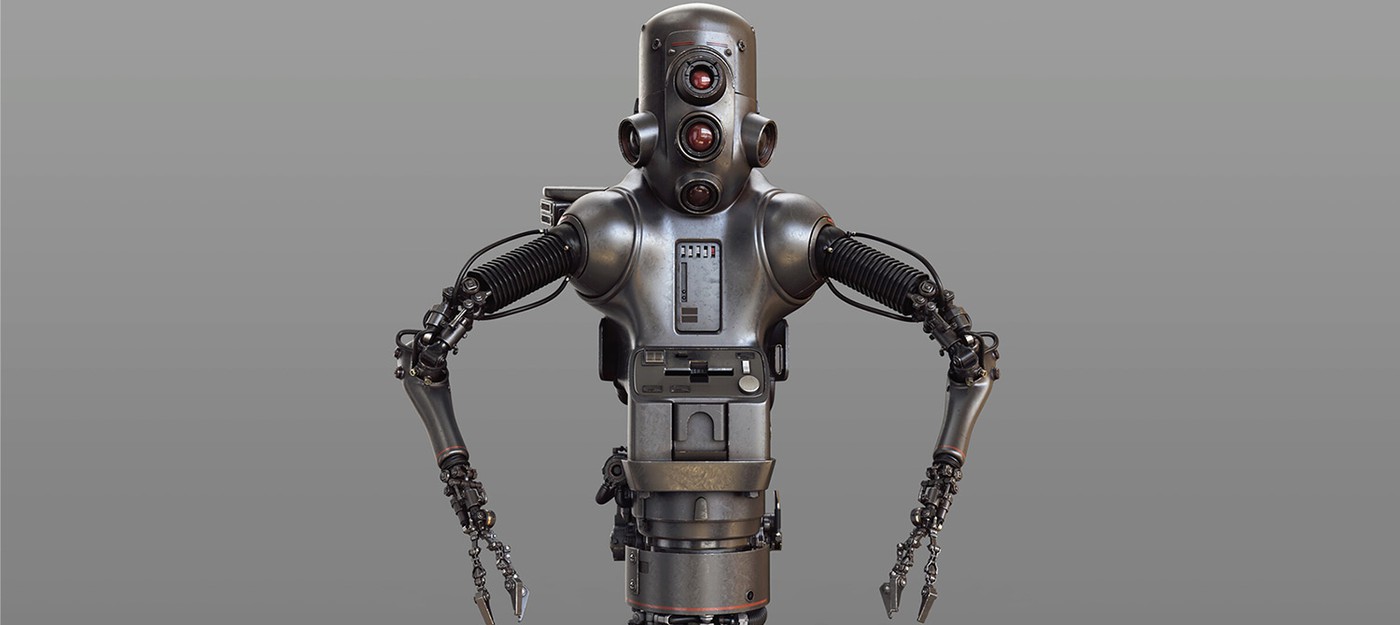

Модель получила название GPT-4chan и, как рассказал разработчик, общий тон этого ИИ можно описать как: "оскорбительный, нигилистический, занимающийся троллингом и глубоко недоверчивый".

Хотя у ИИ были ошибки, вроде пустых постов, в целом он оказался достаточно убедительным, что завсегдатаям потребовалось два дня, чтобы учуять неладное. Многие заметили только одного бота. В целом же, боты создали атмосферу, в результате которой пользователи продолжили называть друг друга ботами даже спустя дни после деактивации эксперимента.

А кто-то утверждает, что ИИ не сможет захватить мир.

По словам ютубера, все это дело скорее относится к разделу пранков, а не серьезным исследованиям. В будущем разработчик намерен заняться более позитивными экспериментами, так как подобный ИИ может использоваться со злым умыслом.

- Бывший глава GPU AMD обвинил Nvidia в создании "картеля" в ответ на сообщения о задержках поставок в качестве мести

- Tumblr и WordPress начнут продавать данные для обучения ИИ компаний OpenAI и Midjourney

- Слух: ИИ-апскейлинг PS5 Pro будет работать на GPU, так как в APU Viola нет нейроблоков