Эксперты предупреждают: ИИ, обучающийся на собственной бессмыслице, может самоуничтожиться

Согласно исследованию, опубликованному в журнале Nature, модели искусственного интеллекта могут деградировать, превращая оригинальный контент в бессвязную чепуху всего за несколько поколений. Это исследование указывает на растущий риск коллапса ИИ-моделей из-за самообучения и необходимость использования оригинальных источников данных и тщательной фильтрации информации.

Коллапс модели происходит, когда искусственный интеллект чрезмерно обучается на данных, сгенерированных ИИ. Илия Шумаилов, исследователь из Оксфордского университета и ведущий автор статьи, объясняет:

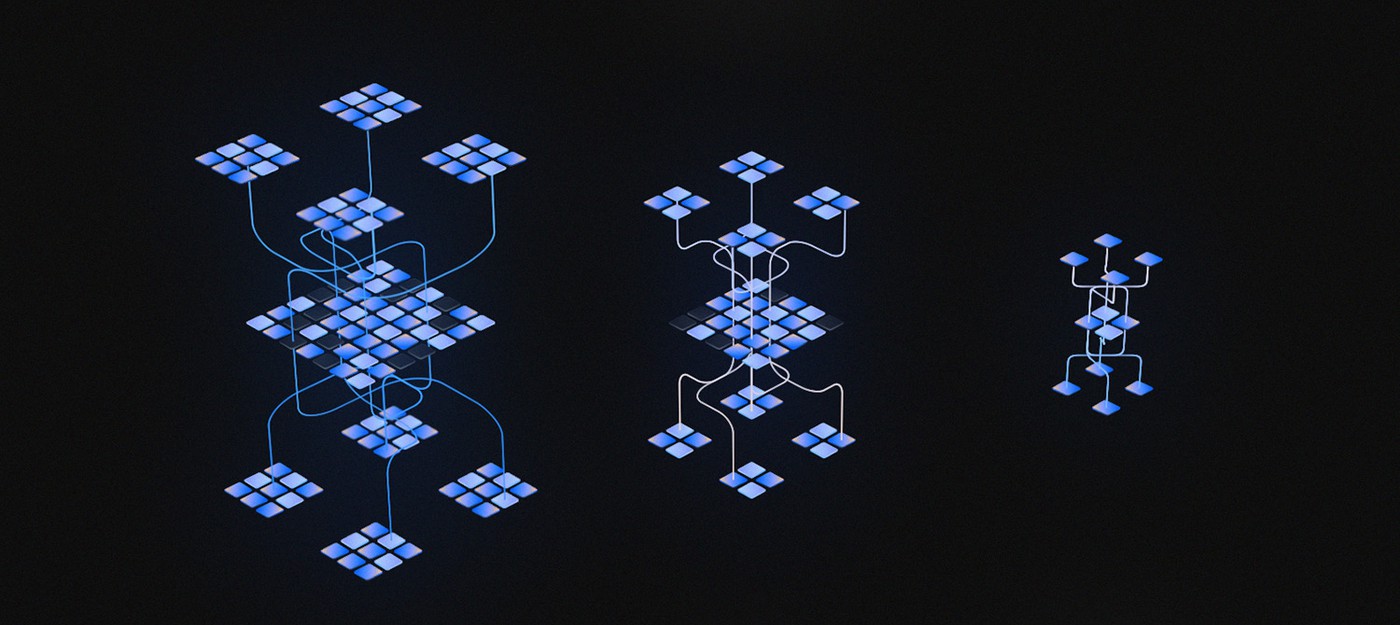

Коллапс модели относится к явлению, когда модели разрушаются из-за неразборчивого обучения на синтетических данных.

Согласно новому исследованию, генеративные инструменты ИИ, такие как большие языковые модели, могут игнорировать определенные части обучающего набора данных, что приводит к тому, что модель обучается только на части данных. Это может привести к тому, что модель быстро превратится в тень своего прежнего "я".

Исследователи приводят пример с использованием модели генерации текста OPT-125m. Команда ввела в модель текст на тему проектирования церковных башен 14 века. В первом поколении выходного текста модель в основном была точной, обсуждая здания, построенные при различных папах. Но к девятому поколению текстовых выводов модель в основном обсуждала большие популяции черных, белых, синих, красных и желтохвостых зайцев-беляков. Стоит отметить, что большинство из этих видов зайцев на самом деле не существует.

Проблема коллапса модели становится все более критичной по мере того, как контент, созданный ИИ, насыщает интернет. Хотя переполненный интернет — не новость, контент, созданный ИИ, может производиться гораздо быстрее, чем человек может писать чушь, что вызывает опасения в более широком масштабе.

Эмили Венгер, специалист по компьютерным наукам из Университета Дьюка, отмечает, что коллапс модели создает проблемы для справедливости в генеративном ИИ. Разрушенные модели упускают из виду менее распространенные элементы из своих обучающих данных и не отражают сложность и нюансы реального мира. Это представляет риск того, что меньшинства или определенные точки зрения будут менее представлены или вовсе стерты.

Тем временем крупные технологические компании предпринимают действия для уменьшения количества контента, созданного ИИ, который видит обычный пользователь интернета. Например, Google объявила, что изменит свой алгоритм, чтобы понизить приоритет страниц, которые кажутся созданными для манипуляции поисковыми системами, а не для потребления людьми.

Авторы исследования подчеркивают, что доступ к исходным данным и тщательная фильтрация данных в рекурсивно обученных моделях могут помочь удержать модели на правильном пути. Они также предлагают координацию между сообществом ИИ, участвующим в создании больших языковых моделей, для отслеживания происхождения информации, подаваемой в модели.

Команда заключает, что если не принять соответствующие меры, может стать все труднее обучать новые версии больших языковых моделей без доступа к данным, собранным из интернета до массового внедрения ИИ-технологии, или прямого доступа к данным, созданным людьми в больших масштабах.

- Фанаты раскрыли тайну "Знаменитости номер шесть" с иллюстрации на шторах

- Старший экипаж корабля ВМС США установил нелегальный Starlink на борту, чтобы подключаться к скоростному спутниковому интернету

- Китайская ракета разрушилась на орбите, оставив опасный след из космического мусора

0 комментариев